Il semble que la plupart des entreprises redessinent leur site Web chaque année ou plus.

Les nouvelles tendances gagnent en vapeur, donc elles veulent être plus « contemporaines » ou « plates ».

Ou de nouveaux schémas de couleurs sont en vogue. Donc, chaque site que vous visitez semble Asana-lumineux.

Tout le monde veut maintenant mettre à jour son site sur la même base régulière.

J’ adore expérimenter avec de nouveaux schémas de couleurs et tendances, aussi.

Sauf pour une petite chose.

Je déteste les reconceptions.

Les mises à jour de conception sont bonnes. Ils vous permettent d’apporter des améliorations incrémentielles pour vous assurer que votre site est à jour.

Mais des reconceptions à grande échelle ?

Où vous remaniez complètement l’architecture du site et le contenu de la page ?

Vous devriez éviter ceux comme la peste.

Je sais que ça semble surprenant. Mais je vais partager quelques exemples de comment et où les reconceptions de site Web vont mal.

Surtout quand il s’agit de détruire tous les classements SEO durement gagnés que vous avez accumulés au fil du temps.

Voici comment éviter saboter vos propres classements SEO avec votre refonte.

Les modifications apportées à l’architecture du site entraînent la perte de liens

Il y a des centaines de facteurs de classement pour le référencement.

Mais les backlinks règnent toujours en suprême.

Les liens externes sont considérés comme des « votes » depuis le début du temps (internet). Leur quantité, leur diversité et leur autorité transmettent le plus d’influence pour élever votre position dans les SERP.

Les liens internes ne comptent pas pour autant de valeur. Cependant, ils ont une influence directe sur l’expérience du site Web de quelqu’un.

Je vais t’expliquer.

En 2011, Google Panda est sorti. Il s’agit de l’un des premiers cas signalés où Google a confirmé l’utilisation de facteurs qualitatifs.

Ils ont utilisé un sondage avec des questions telles que :

- Confieriez-vous les informations de ce site Web ?

- Ce site est-il écrit par des experts ?

- Donneriez-vous à ce site vos coordonnées de carte de crédit ?

- Les pages de ce site ont-elles des erreurs évidentes ?

- Est-ce que le fournir du contenu original ou des informations ?

- Reconnais-tu ce site comme une autorité ?

- Ce site Web contient-il une analyse perspicace ?

- Enviseriez-vous des pages de signet sur ce site ?

- Y a-t-il des publicités excessives sur ce site ?

- Les pages de ce site peuvent-elles apparaître en version imprimée ?

Et ils ont eu des gens évaluent individuellement différents sites Web.

Avance rapide quelques années, et Google a également commencé à prendre en compte le comportement des utilisateurs.

Ils ne veulent pas seulement classer les sites Web en fonction des liens ou de la longueur du contenu. Ils veulent également se pencher sur l’expérience globale de ce site Web.

Ils veulent s’assurer que les gens trouvent ce qu’ils recherchent.

Ainsi, plus les visiteurs ont une meilleure expérience, plus le site aura de crédit.

Quelle est une façon de ruiner une expérience autrement agréable ?

Liens cassés qui font dérailler le chemin d’une personne à travers votre site.

Lorsque la plupart des entreprises redessinent des sites Web, elles commencent à jouer avec le site architecture.

Ils créent de nouvelles pages et abandonnent les anciennes. Ou ils prennent du contenu d’une page et l’ajoutent à une autre.

Ensuite, ils changent leurs menus et leurs schémas de navigation.

Il semble inoffensif à la surface. La nouvelle expérience pourrait même être supérieure à l’ancienne.

Mais ce qu’ils ne réalisent pas, c’est qu’ils créent souvent une tonne de problèmes pour le référencement.

Pour commencer, les modifications de l’architecture de site peuvent ruiner les pages du hub que vous avez travaillé dur à créer.

Ce sont comme des clusters de pages connexes sur votre site. Et ils peuvent aider à augmenter votre autorité perçue sur ces sujets.

Les modifications au niveau de la page créent également des liens internes rompus dans tout le site.

Tu connais la perceuse. Vous essayez de cliquer sur une nouvelle page pour trouver des informations connexes, uniquement pour être satisfait par une erreur 404.

Un ou deux n’est pas un gros problème. Cependant, les reconceptions en créent souvent une tonne à la fois.

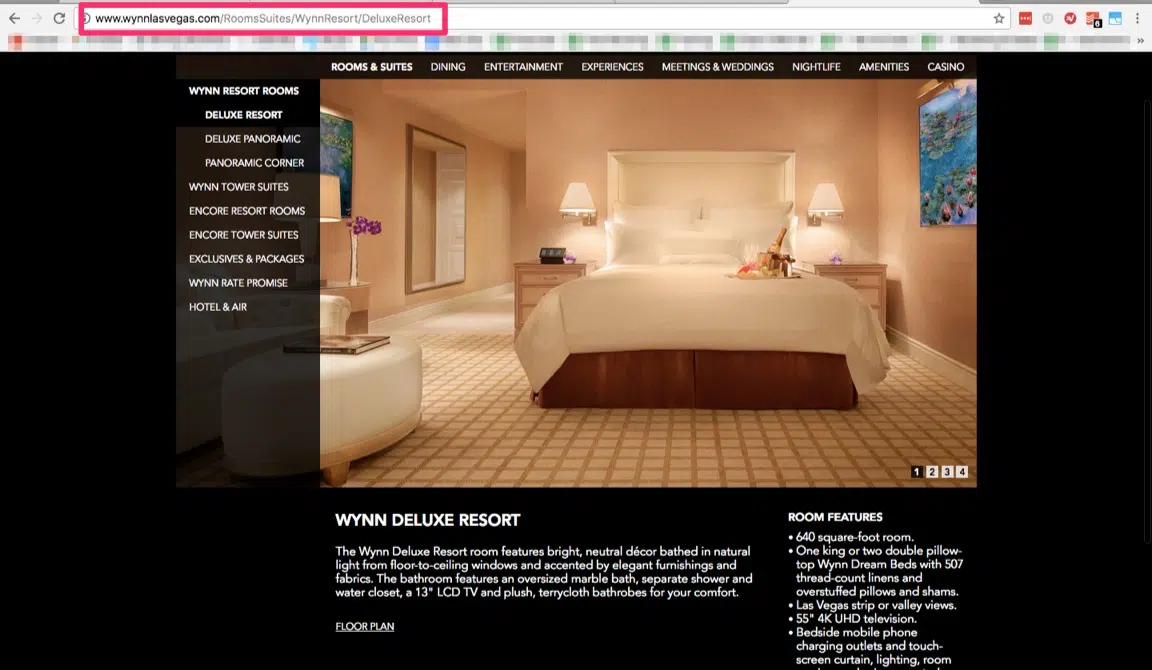

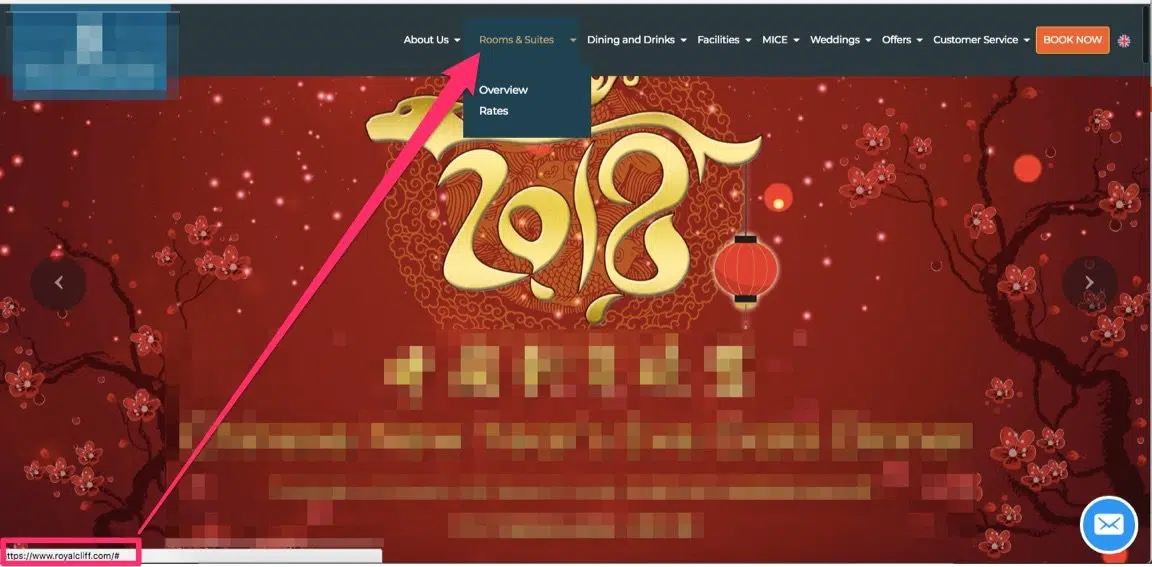

Par exemple, disons que vous redessinez un hôtel ou site de commerce électronique.

Il y a des chances que vous utilisez une structure parent-enfant détaillée pour organiser les pages.

Cela signifie que vous pouvez avoir des « chambres » en haut, suivies par les types individuels de pièces en dessous.

Le problème est que ces structures changent souvent avec le temps.

Peut-être que vous venez avec de nouveaux produits ou services. Peut-être que vous migrez de vieilles chambres dans de nouvelles chambres.

Un changement apparemment petit peut souvent créer un effet d’ondulation sur tout votre site.

Il peut être tout à fait logique de déplacer vos chambres en vedette d’un niveau ou deux.

Cependant, toute modification apportée à vos structures d’URL ne crée pas un ou deux liens rompus.

Il peut littéralement créer des centaines à des milliers.

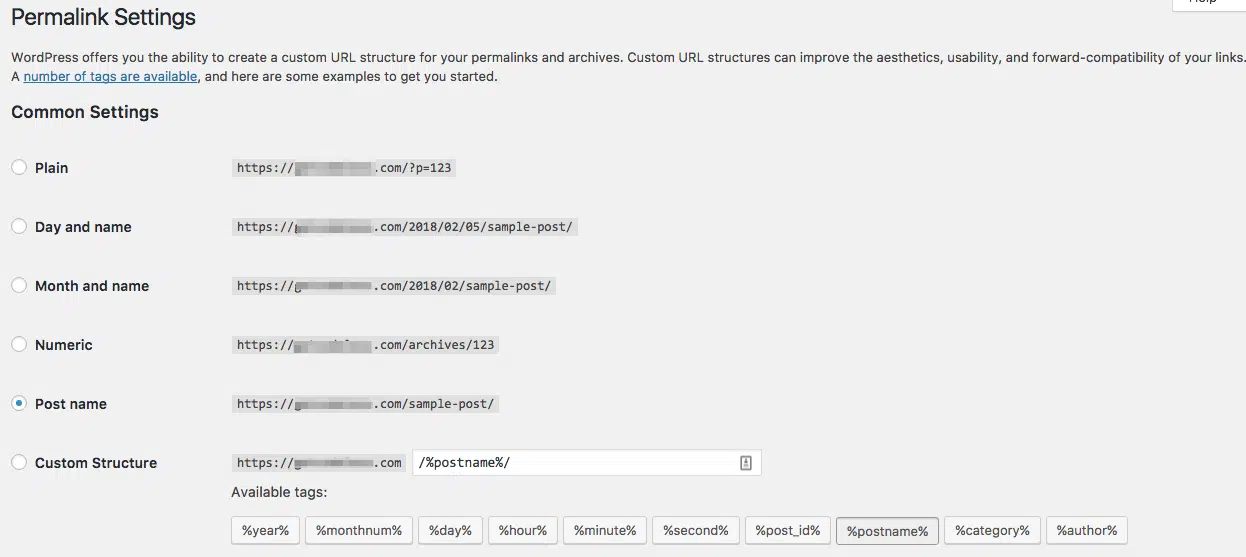

Prenez les blogs par exemple.

Supposons que vous avez travaillé dur au fil des ans pour créer des centaines ou des milliers de billets de blog.

Mais quand vient le temps de passer à un nouveau CMS lors d’une refonte du site, quelqu’un veut supprimer les chaînes de date de la URL.

Heck, tout ce qu’il faut est littéralement un seul clic à l’intérieur de WordPress pour mettre à jour les paramètres Permalink.

Donc oui, ça semble inoffensif.

J’ ai vu cette erreur maintes et maintes fois.

Les propriétaires d’entreprise pauvres, sans méfiance qui ont leurs sites Web entiers pratiquement briser.

Des dizaines de milliers d’URL de page se rompent du jour au lendemain.

Et tu sais ce qui arrive à leur classement ?

Ils tombent comme un rocher.

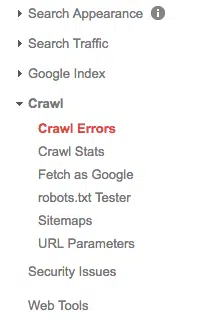

Heureusement, Google Search Console peut vous aider à repérer les liens cassés sous le rapport d’analyse.

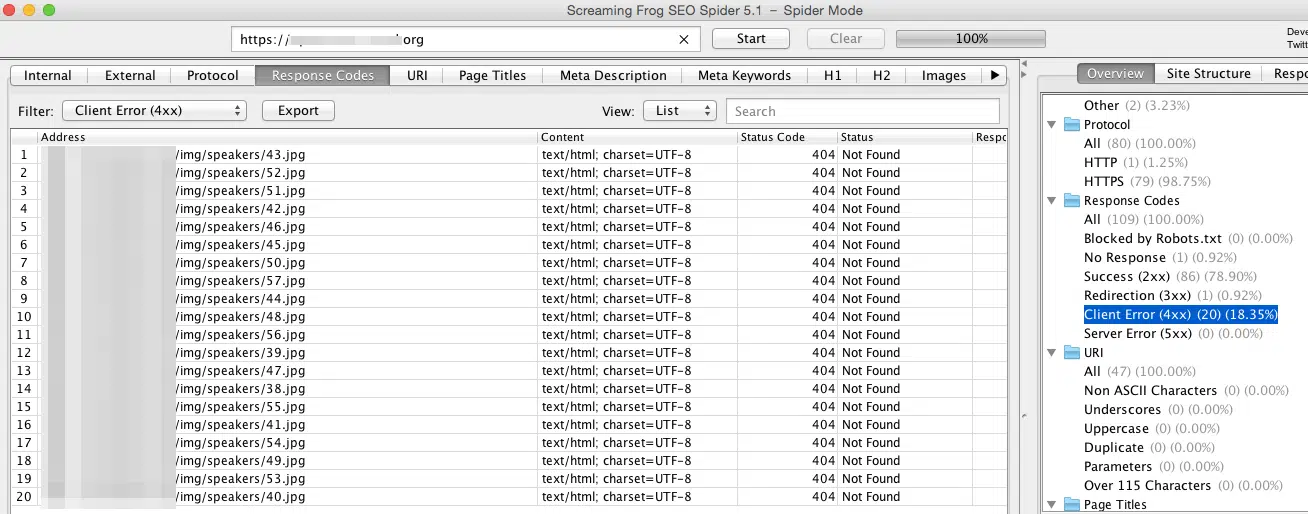

Mon outil préféré pour les audits SEO techniques est Screaming Frog.

Il va explorer chaque page de votre site, découvrant des tonnes de problèmes de référencement sur site.

Par exemple, vous pouvez commencer par rechercher le rapport « Erreur client (4XX) » sous Codes de réponse.

La plupart d’entre eux seront 404 erreurs, lorsque l’état est signalé comme « Not Found ».

Jusqu’ à présent, nous nous sommes concentrés presque exclusivement sur les liens.

Mais ce n’est pas la seule façon dont les modifications apportées à la conception peuvent affecter les liens de votre site.

Pensez-y de cette façon.

Les pages ou les publications plus anciennes et de haute autorité ont tendance à acquérir le plus de backlinks.

Les liens de valeur la plus élevée sont également les plus difficiles à obtenir. Il s’agit, par exemple, de liens éditoriaux provenant de journalistes ou d’autres influenceurs.

Cela signifie aussi que vous ne pouvez pas les contrôler.

Ainsi, lorsque votre page ou votre URL de publication change, vous perdrez tous ces liens externes, aussi.

Cela, encore une fois, arrive tout le temps.

Les mises à jour de permalien, le déplacement du blog d’un sous-dossier vers un sous-domaine, ou même simplement de nouvelles pages produit remplaçant les anciennes pages peuvent vous forcer à perdre tous ces liens backlinks.

La meilleure solution ? Ne modifiez pas les anciennes URL de page !

Du moins, pas si vous pouvez l’aider.

Sinon, une autre façon d’écarter ce problème consiste à configurer les redirections 301.

Ce sont des redirections « permanentes », indiquant aux moteurs de recherche que la nouvelle page a maintenant remplacé l’ancien.

La Page Rapide/Post Redirect Plugin pour WordPress est l’une des options les plus populaires.

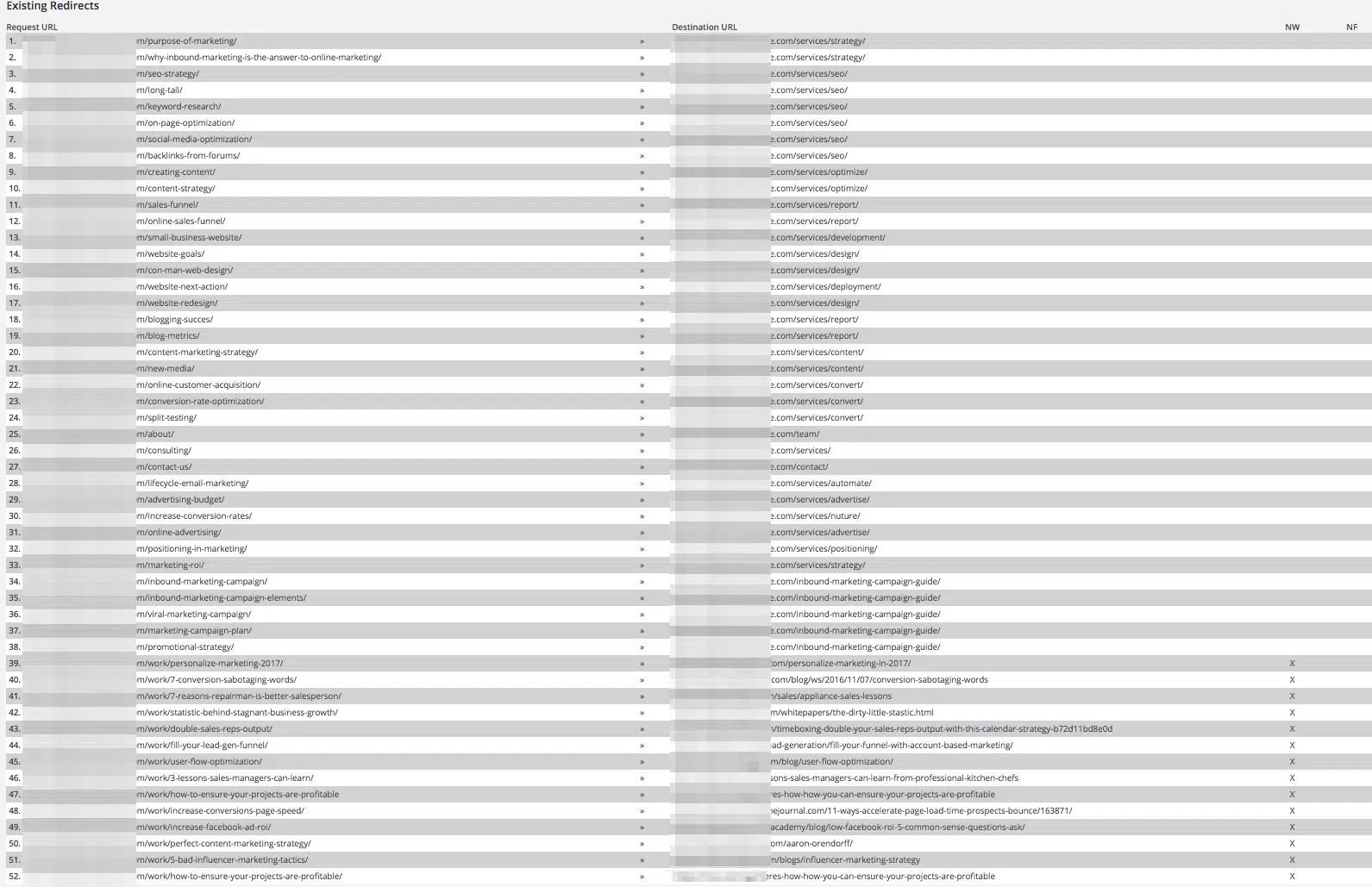

Il est également incroyablement facile à utiliser. Tout ce que vous avez à faire est de déposer l’ancienne URL « Demande » puis de la diriger vers la nouvelle « Destination ». La seule mise en garde est que les redirections comme celles-ci doivent être utilisées avec parcimonie.

Ce que vous ne voulez pas voir, c’est quelque chose comme ceci :

Le chargement d’un trop grand nombre de redirections 301 peut entraîner d’autres conséquences involontaires. Et ils sont généralement un signe qu’il y a un problème sous-jacent plus important en jeu.

Cela signifie que l’architecture du site a changé radicalement.

Voici pourquoi trop de redirections peuvent également affecter vos classements SEO.

Trop de redirections 301 peuvent entraîner des vitesses de page lentes

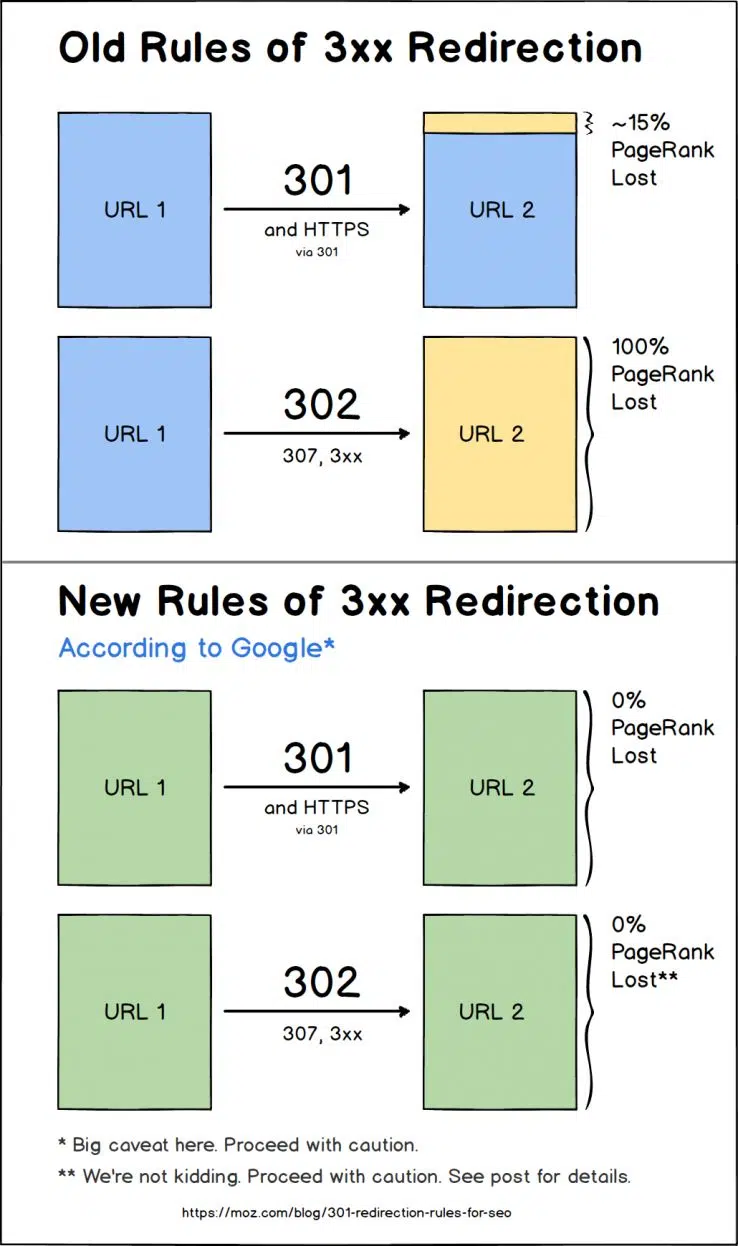

Les redirections « 301 » ont longtemps été considérées comme les meilleures pour le référencement.

Ils indiquent un changement « permanent », par opposition à un changement « temporaire » comme un 302 dégage.

Quoi qu’il en soit, les référencement craignaient toujours que les redirections limiteraient en quelque sorte la quantité de PageRank qui a traversé le site.

Même Google propre Matt Cutts une fois indiqué une certaine perte.

Mais en 2016, l’analyste Google webmaster, Gary Illyes, a confirmé que tous les liens 3XX passent la pleine valeur :

Un autre Googler, John Mueller, a confirmé les mêmes résultats.

Pourquoi tout cela a-t-il d’importance ?

Parce que les redirections sont souvent utilisées pour mettre à jour les sites Web vers HTTPS. Donc, certains référencement pensent que c’est la façon de Google de s’assurer que les gens l’adoptent.

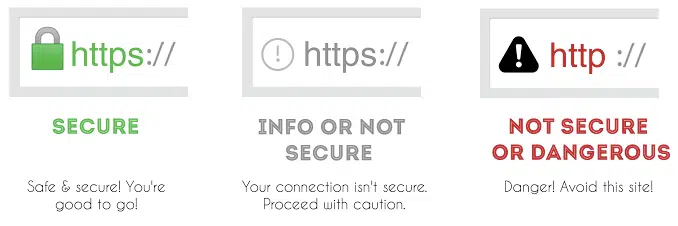

L’ année dernière, les utilisateurs de Google Chrome ont commencé à voir de nouveaux avertissements de sécurité.

Auparavant, jusqu’à 70 % des utilisateurs ignoraient les avertissements de sécurité du site Web. Google a donc déployé de nouveaux messages « Non sécurisé » pour les sites qui ne configurent pas de certificats SSL.

Passer de HTTP à HTTPS n’est pas aussi simple que vous pourriez le penser.

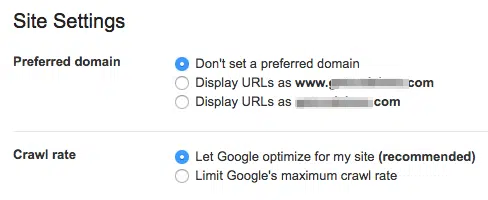

Par exemple, vous pouvez simplement basculer un commutateur dans Google Search Console pour choisir le « domaine préféré » de votre site.

De cette façon, vous évitez les problèmes potentiels de canonicalisation de votre site reconnu comme deux : une option « www » et « non-www ».

Comme discuté, toute modification d’URL peut vous faire perdre des liens.

Les modifications d’architecture peuvent rompre les liens internes. Mais vous pouvez également perdre sur « l’équité des liens » si les sites sont liés à HTTP et non à la nouvelle version HTTPS-de votre site.

Encore une fois, pourquoi sommes-nous sur les redirections ?

Parce que trop de personnes peuvent ralentir les performances de votre site.

Et la vitesse de la page a été officiellement confirmée comme facteur de classement.

Kinsta a exécuté un test sur WordPress pour voir comment les redirections affectent la vitesse de la page.

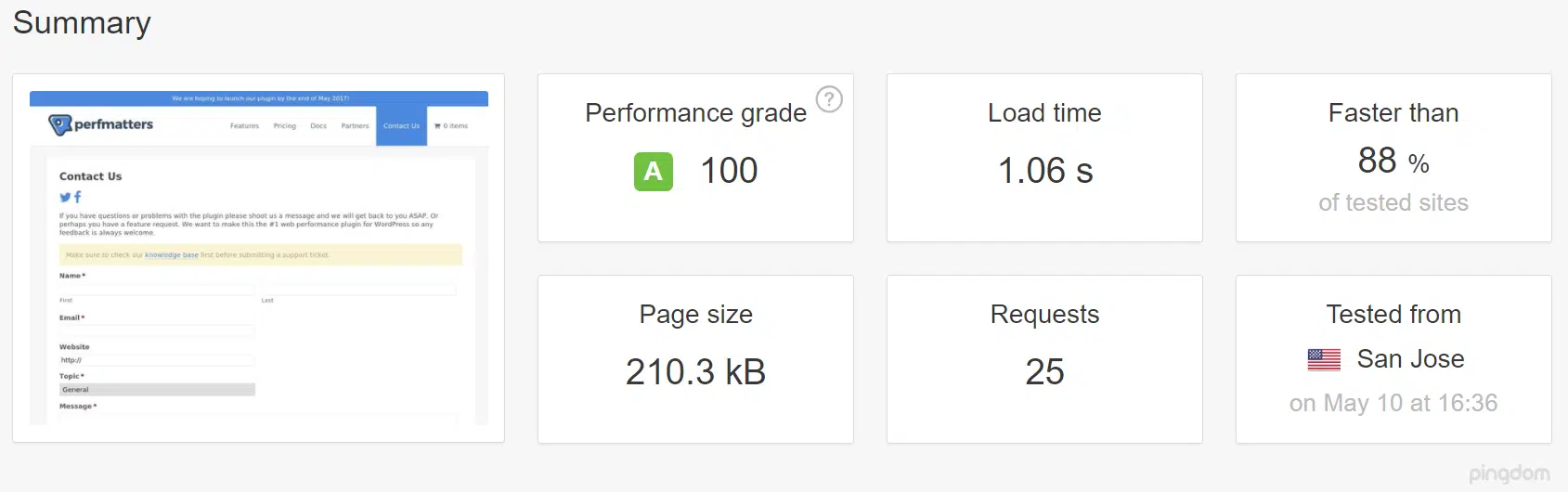

Tout d’ abord, ils ont utilisé Pingdom pour exécuter un rapport de vitesse de page sans redirection.

La page a été chargée en environ 1.06 secondes. C’est un bon score !

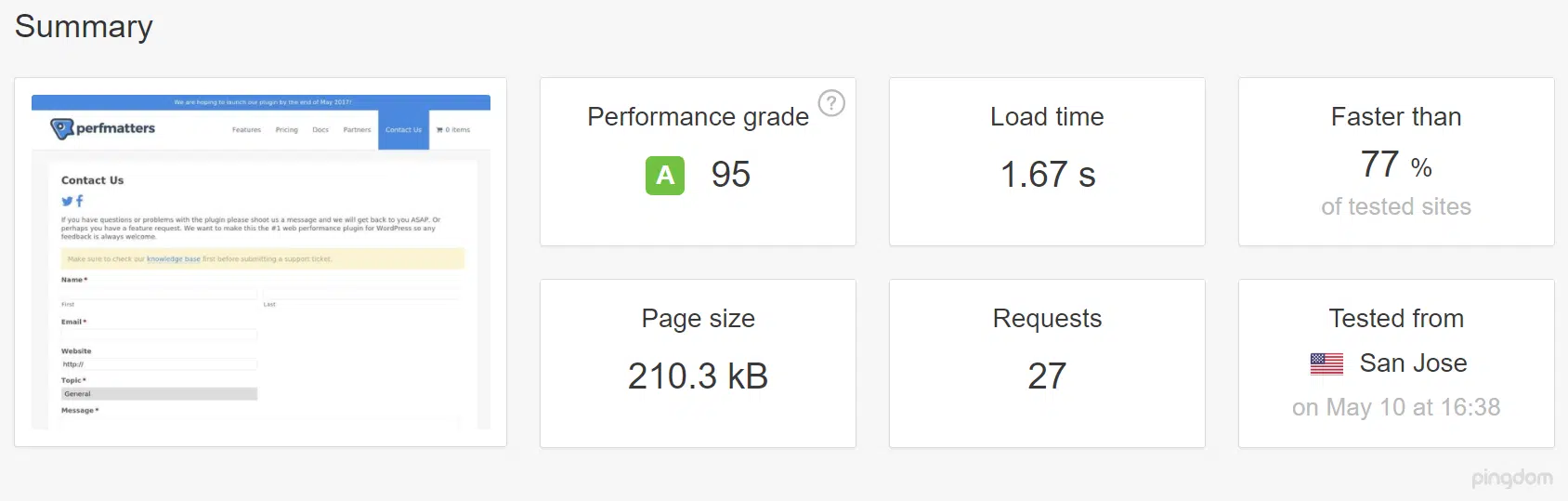

Ensuite, ils ont recommencé le test. Mais cette fois, à travers une URL redirigée.

Et découvrez comment cela a affecté le temps de chargement de la page :

Fou, c’est ça ?

A rediriger une augmentation du temps de chargement de la page de 58%.

C’ est juste une redirection d’une seule page, aussi.

Multipliez cela sur des dizaines de redirections et vous pouvez voir le problème.

Pire encore, c’est quand plusieurs redirections se produisent juste après l’autre.

Cela se produit souvent si vous avez mis à jour une page plusieurs fois. Comme dans, plusieurs reconceptions au fil des ans.

Une URL redirige vers une autre, qui se redirige vers une autre. Et la vitesse de la page ralentit à une exploration.

Mon outil préféré pour diagnostiquer les redirections est l’outil de mappeur de redirection de Patrick Sexton.

Tout ce que vous avez à faire est de déposer votre URL :

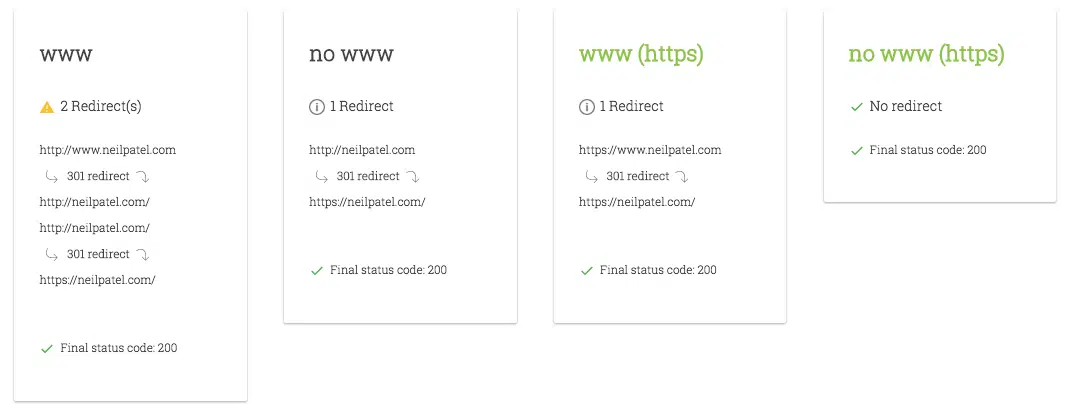

Appuyez sur « Go », et vous obtiendrez instantanément des commentaires sur les différentes redirections 301 configurées au fil des ans :

Encore une fois, moins c’est mieux. Google, eux-mêmes, dit littéralement d’éliminer autant que possible.

Ce qui peut être un problème si vous avez mis à jour le contenu pendant les reconceptions.

Voilà pourquoi.

Messages de contenu mis à jour avec ciblage par mots clés et page

optimisation Pourquoi configurer deux redirections pour une seule page ?

Ça n’a pas de sens, n’est-ce pas ?

Bien sûr que non. Du moins, pas intentionnellement.

Pourtant, cela arrive toujours tout le temps.

Voilà pourquoi.

Il y a cinq ans, vous avez vendu un produit ou un service. Il y a trois ans, ça a changé. Et cette année, ça change à nouveau.

En d’autres termes, le but derrière la page évolue au fil du temps. Ainsi, tout le contenu de la page change aussi.

Cela arrive même avec le contenu gratte-ciel. Vous prenez beaucoup de vieux messages qui sont sous-performants, et les redirigez vers un nouveau.

Au lieu de trop compter sur les redirections, ils devraient simplement « rafraîchir » ces anciens messages. L’ajout de nouveaux contenus et images peut augmenter le trafic SEO de 111 %.

Plusieurs redirections dans une rangée provoquent des problèmes de performances.

Cependant, l’évolution constante du contenu de la page est également gênante avec le ciblage de vos mots clés et l’optimisation sur site.

Voici comment.

Revenons à un exemple de l’hôtel.

Initialement, peut-être qu’ils n’ont qu’un deux types de chambres. Mais après une rénovation, ceux-ci sont agrandis.

L’ architecture originale du site Web pourrait simplement énumérer les premières salles sur la même page. Mais maintenant, il y en a trop.

Vous changez donc la page « Chambres » par une page de catégorie, qui répertorie celles qui se trouve en dessous.

Le problème est que maintenant votre page « Chambres » a également zéro contenu. Il sert simplement de liste déroulante maintenant :

Si cette page « Chambres » était classée précédemment, elle ne l’est plus.

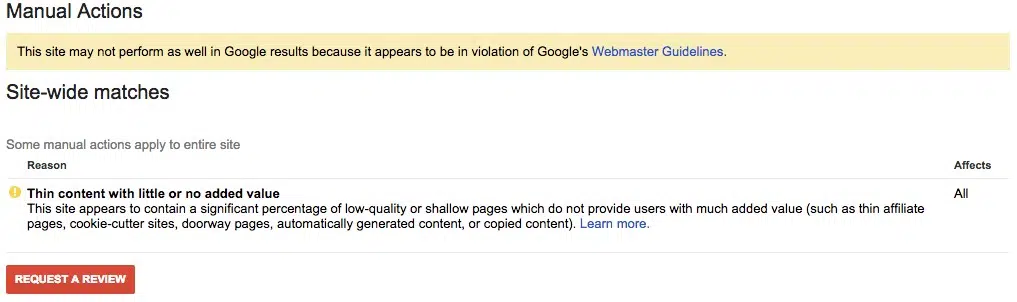

Maintenant, vous avez des problèmes de contenu minces, pour commencer. C’est quand il y a moins de 300 mots sur les pages individuelles de votre site :

La longueur de la page compte parce que l’analyse de Backlinko a montré que « le résultat moyen de la première page sur Google contient 1.890 mots. »

50 % des requêtes de recherche contiennent également quatre mots. Cela signifie que quelqu’un tape un mot-clé long tail pour trouver quelque chose de spécifique sur cette page.

C’ est dur. pour donner aux gens les informations dont ils ont besoin si vous avez littéralement supprimé la totalité (ou la plupart) du contenu.

Les changements de contenu lors de la refonte du site causent également des ravages sur les métadonnées des pages.

L’ une des trois choses se produit habituellement dans ce cas :

- Le contenu de la page a changé, de sorte que les anciennes métadonnées ne sont plus pertinentes

- Les nouvelles métadonnées sont copiées et collées à partir d’autres sites

- Ou les concepteurs et développeurs ont complètement négligé d’ajouter des métadonnées aux pages mises à jour

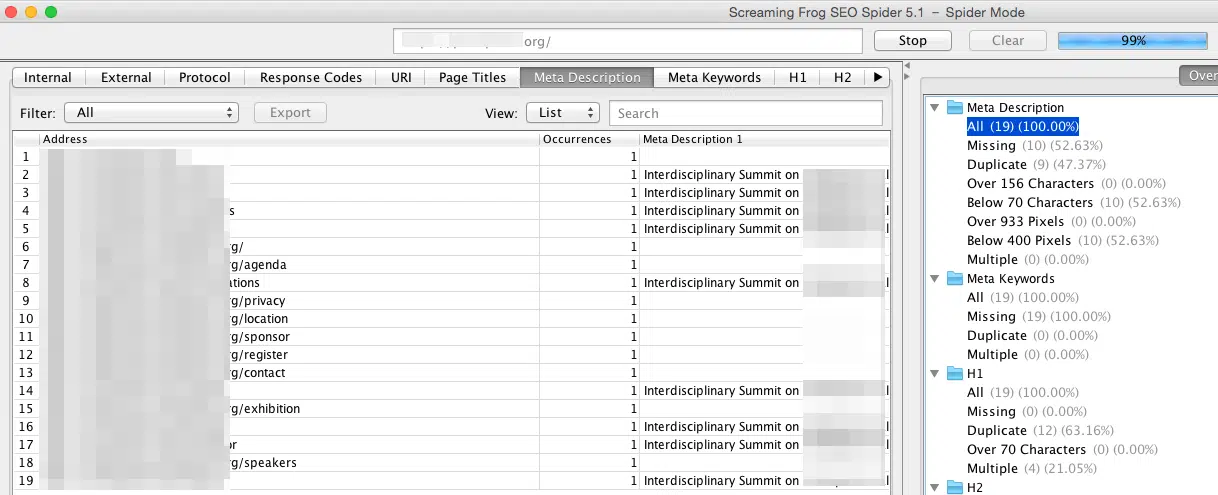

Encore une fois, Screaming Frog peut vous aider à diagnostiquer ces problèmes.

Déposez votre URL et recherchez l’option meta description. J’aime commencer ici, car cela indique généralement un plus gros problème en jeu.

Par exemple, consultez l’exemple suivant. J’ai brouillé le nom du site pour protéger les innocents.

Deux problèmes se produisent ici. Tout d’abord, le même mot-clé est répété sur plusieurs pages. Cela pourrait conduire à des problèmes de contenu en double et réduire leur capacité d’obtenir une page principale à classer pour ce terme.

Deuxièmement, il y a une tonne de pages qui manque entièrement une méta-description.

Techniquement, les méta-descriptions ne vous aident pas à classer. Ils vous aident cependant à augmenter vos taux de clics SERP (CTR). Et de nouvelles données suggèrent que la CTR peut souvent influer directement sur les classements.

Si une page n’a pas de méta-description, les moteurs de recherche retirent souvent le contenu directement de la page.

Mais dans la plupart des cas, c’est du texte aléatoire qui est tronqué car il dépasse les exigences de longueur.

Donc ce n’est pas idéal. Et les gens ne cliquent pas.

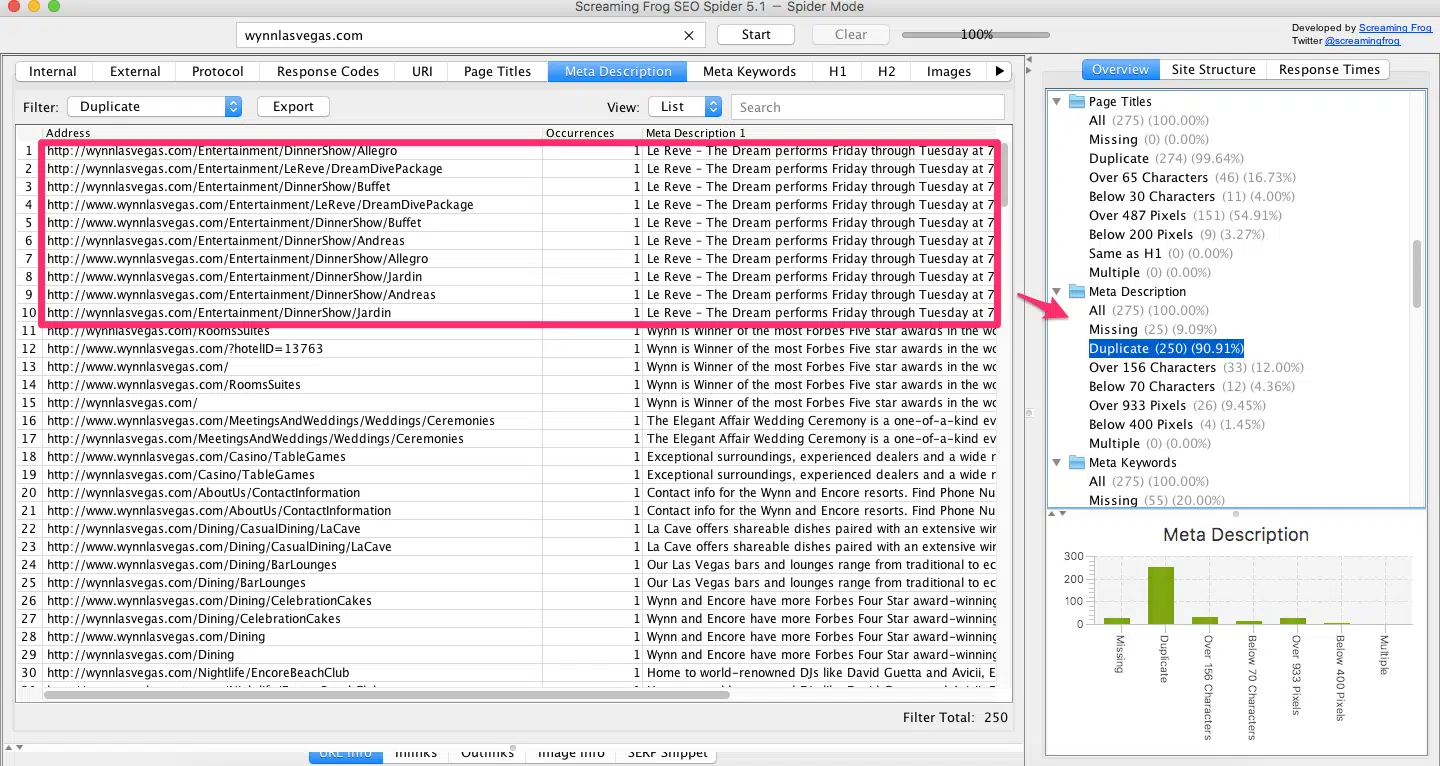

Voici un autre problème commun à rechercher :

Nous regardons différentes pages de restaurants sur un site Web. Cependant, ils partagent tous la même méta-description exacte.

Encore une fois, c’est un drapeau rouge.

Les métadonnées dupliquées cannibalisent les chances que votre page principale soit bien classée pour ce terme.

Et ces incohérences indiquent généralement un problème plus important en jeu.

La plupart des entreprises spécialisées dans la conception ne toucheront pas les métadonnées de la page.

Le référencement n’est pas une grande priorité pour eux. Ils n’ont peut-être pas les spécialistes en personnel.

C’ est donc ce qui se passe. Vous obtenez des sites Web expédiés qui ont l’air fantastique, mais ne fonctionnent pas.

Les pages ont les mêmes métadonnées copiées. Ou pire encore, les balises de titre et les descriptions sont complètement manquantes.

Et à la fin de la journée, la seule chose qui compte, c’est le fonctionnement de votre site Web, et non son apparence.

Les reconceptions vissent ‘flux utilisateur qui fonctionnent déjà

Mon plus gros problème avec les reconceptions de sites Web est qu’ils gâchent souvent ce qui fonctionne déjà.

Si votre entreprise est en activité, il est probable que vous ayez déjà des achats en cours chaque jour.

Les reconceptions qui changent l’architecture du site ou le contenu de la page sont souvent fous.

Vous mettez complètement en péril les revenus.

Et finalement, la capacité de votre site Web à générer des revenus est son aspect le plus important.

Changer tout cela, sans savoir si le nouveau design va se convertir ainsi que l’ancien design, est un énorme pari.

Les résultats pourraient augmenter. Mais tu ne sais pas à coup sûr. C’est exactement le problème.

Pensez-y de cette façon.

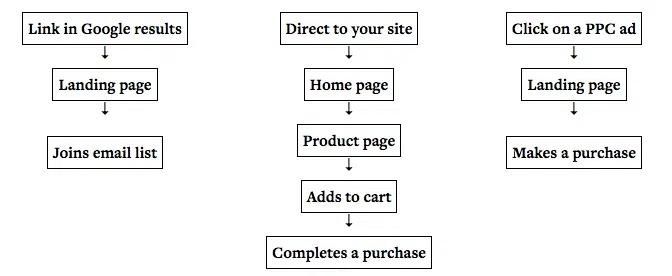

La macro-conversion d’un site web, comme un achat, est constituée de micro-conversions.

Pour obtenir une vente, vous devez d’abord amener des gens à votre site. Ensuite, leur faire visiter certaines pages. Alors peut-être opt-in quelque chose avant qu’ils aient plus de paiement.

Ces « flux utilisateur » sont déjà diffusés sur votre site Web.

La modification de la séquence de ces étapes peut avoir des ramifications massives sur l’objectif final.

C’ est le point derrière l’optimisation de la conversion que la plupart des gens manquent.

Ils pensent que « optimisation de conversion » signifie changer la couleur d’un bouton ou un titre.

Mais en réalité, changer la façon dont les gens circulent sur votre site peut souvent avoir un impact plus important sur achats.

Une étude, par exemple, a révélé que l’optimisation du flux de paiement du commerce électronique pourrait entraîner une augmentation de 87 175 $/mois. Cette augmentation de conversion de ~ 3 % pourrait ajouter une autre 23,94 % à leur ligne supérieure.

Les micro-conversions s’étendent également aux liens internes de vos pages. Ceux-ci sont comme le début d’un nouveau chemin à travers votre site.

Changer ces liens ne semble pas être un gros problème. Cependant, maintenant vous pouvez voir, que cela pourrait avoir un impact important sur la façon dont les gens achètent vos produits ou services.

Comment évitez-vous cela ?

Encore une fois, la mise à jour de la conception de votre site est une bonne chose. Mais faites-le incrémentiellement afin que vous puissiez tester les effets sur chaque page.

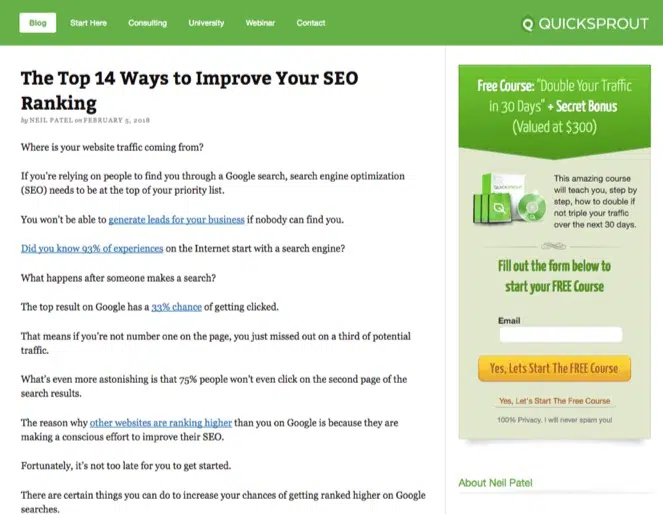

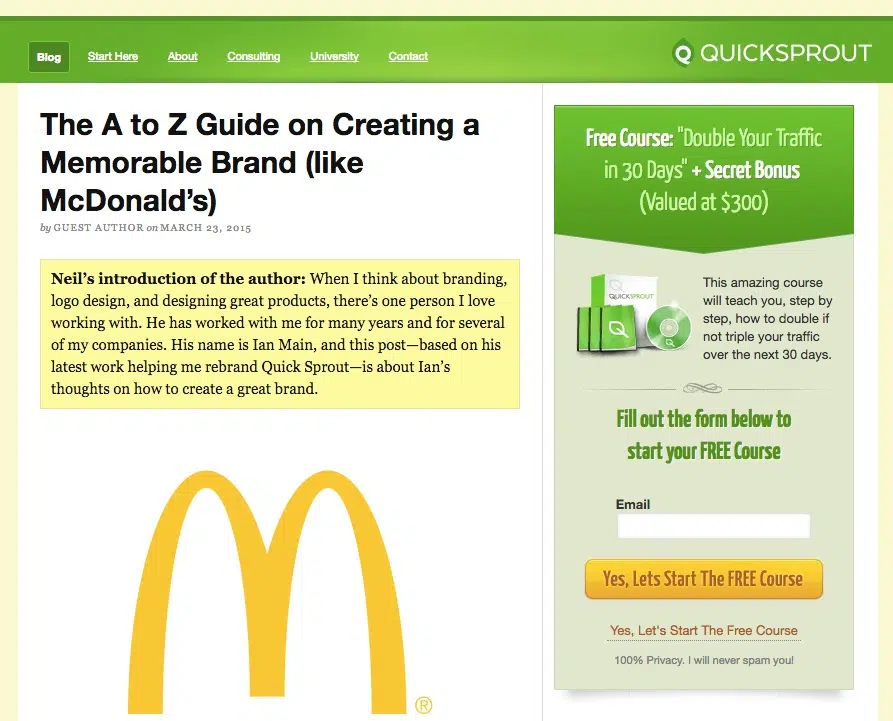

Par exemple, voici à quoi ressemblait mon blog Quick Sprout il y a quelques jours :

Maintenant, comparez ça à ce qu’il avait l’air il y a quelques années. Vous pouvez le faire vous-même en utilisant la machine Wayback.

Assez similaire, non ?

Bien sûr, il semble plus « propre » et « polie » maintenant. Le design est toujours pertinent pour aujourd’hui.

Cependant, je ne voulais pas changer ce qui fonctionnait déjà. C’est comme ça que j’aime exécuter des reconceptions de site Web. Je vais modifier élément par élément ou page par page.

Ensuite, j’utiliserai quelque chose comme Crazy Egg pour faire des tests après chaque changement.

Si les chiffres diminuent, je reviendrai à l’ancien modèle. Même si cela semble un peu désuet.

Mais si les chiffres montent, je commencerai à porter ces nouvelles mises à jour de conception sur mes autres pages.

De cette façon, vous ne devriez jamais perdre le classement SEO à la suite d’une refonte de site Web.

Ou, plus important encore, vous ne perdrez pas de revenus non plus.

Conclusion

Les mises à jour de conception du site Web devraient se produire régulièrement

Les tendances du design changent assez fréquemment. Et vous voulez vous assurer que votre site Web reflète correctement votre marque.

Ce que vous ne voulez pas faire, cependant, c’est saboter tout ce qui fonctionne.

Les reconceptions de sites à grande échelle peuvent souvent créer des tonnes de problèmes.

Les modifications apportées à l’architecture du site peuvent entraîner des problèmes de performances. Les modifications de contenu ruinent le ciblage de vos mots clés. Et la modification des micro-conversions peut faire glisser vos macro-conversions vers le bas.

La façon dont votre site Web ressemble est importante. Mais seulement jusqu’à un certain point.

La question la plus importante est de savoir si les revenus augmentent ou diminuent.

Les reconceptions de sites Web peuvent facilement gâcher votre référencement. Il en résulte des fluctuations des classements et une diminution du trafic.

La baisse du trafic entraîne donc une baisse des revenus avec elle.

Évitez ce problème en ne changeant pas ce qui fonctionne déjà. Si vous voulez mettre à jour quelque chose, faites-le sur de petits éléments, d’abord.

De cette façon, vous pouvez tester l’impact isolément. Vous pouvez voir si cela va augmenter ou diminuer les résultats à petite échelle.

Ensuite, vous pouvez revenir à l’ancien design si cela ne fonctionne pas sans perdre trop de trafic ou de revenus.

Et si cela fonctionne, vous pouvez commencer à appliquer ces mises à jour éprouvées sur le reste de votre site.

Les sites Web ne sont pas seulement des déclarations de mode. Le plus souvent, la fonctionnalité et les performances devraient l’emporter sur l’apparence.

Avez-vous déjà connu des chutes de trafic juste après un nouveau site web ?